喂,搞工厂自动化的老铁们!你们有没有遇到过这种情况:流水线上的零件嗖嗖地跑,机械手一抓却扑了个空?🤯 或者明明装了摄像头,产品稍微换个角度就认不出来了?今天咱就掰开了揉碎了聊聊——机器视觉到底咋搞定高速移动目标的精准定位!

🎯 一、动态定位为啥这么难?

想象一下,你拿着手机拍狂奔的哈士奇——拍糊都是轻的,更别说精准测量它鼻尖的位置了!输送线上的目标定位难点就三个:

- 目标在动:皮带速度动不动1m/s以上,相机一眨眼目标就跑出视野了;

- 环境干扰:车间光照变化、设备震动、粉尘油污全在捣乱;

- 姿态多变:零件可能歪着、叠着、甚至反着躺传送带上。

某汽车厂就吃过亏:机械手抓变速箱壳体,10次里漏抓3次,一条线一天浪费上万元!😤

🔍 二、精准定位的”传感器组合拳”

单靠一个摄像头?悬!高手都是”多传感器融合”:

| 传感器类型 | 能干啥 | 举个栗子 |

|---|---|---|

| 工业相机 | 拍外观、找特征点 | 识别零件二维码 |

| 激光雷达 | 测距离、建3D模型 | 检测堆叠高度 |

| 光电编码器 | 跟踪皮带位移 | 计算移动距离 |

| 接近传感器 | 检测有无物体 | 触发相机拍照 |

为啥要这么多? 你想想——编码器告诉系统”皮带走了3cm”,相机同时确认”零件在画面左上角”,激光雷达补充”它离机械手还有50cm”,数据一拼凑,位置就锁死了!🔐

🧠 三、核心算法:让机器”看懂”动态目标

光有硬件不够,还得靠软件”脑补”关键信息:

1️⃣ 特征匹配法:给零件办”身份证”

- 传统玩法:用SIFT、ORB算法找零件的角点、边缘特征(像认人靠痣或伤疤);

- 致命伤:零件被遮挡或反光就抓瞎,调参数调到头秃…

2️⃣ 深度学习法:让AI自己”悟”

- 绝活:用卷积神经网络(CNN)训练模型,哪怕零件只露出半截,AI也能脑补全貌(就像你只看朋友后脑勺也能认出人);

- 实战案例:某钢筋厂用深度学习数钢筋,99.9%准确率!比老师傅肉眼数快10倍。

3️⃣ 动态补偿术:和时间赛跑

- 预测轨迹:卡尔曼滤波器根据历史位置+皮带速度,预判0.5秒后目标在哪;

- 位置校准:像快递分拣线用”基准反光板”,经过激光测距仪时就校正位置误差。

举个栗子🌰:某手机壳生产线,机械手抓取成功率从70%→99%,秘诀就是”深度学习识别+激光实时校准”双保险!

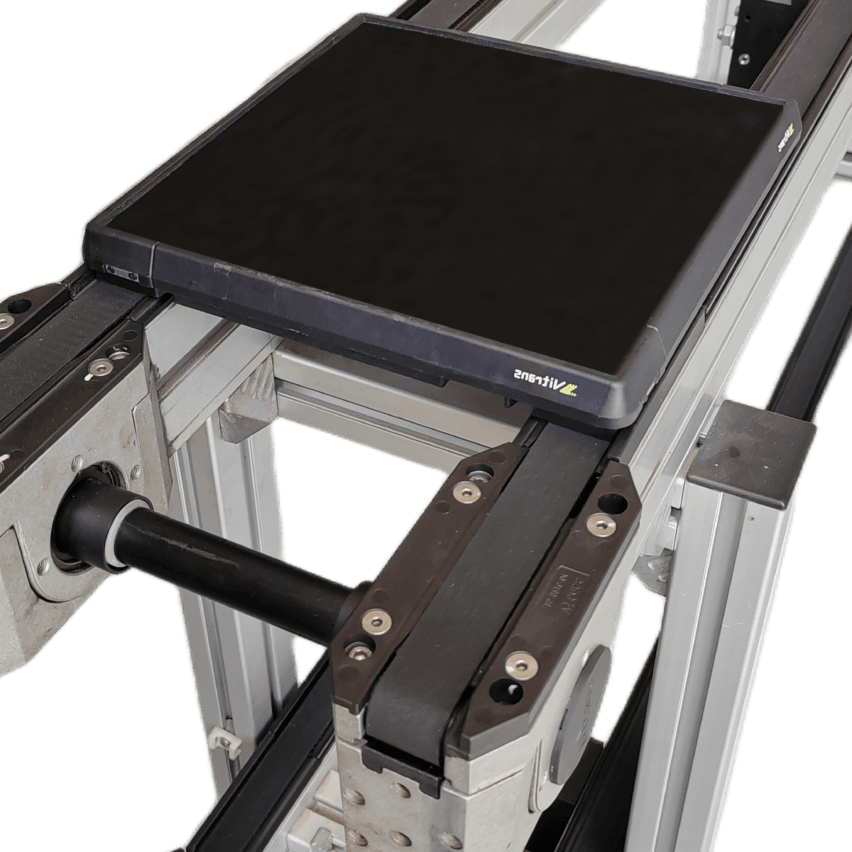

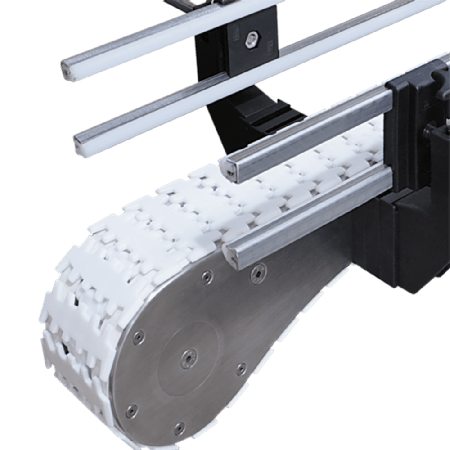

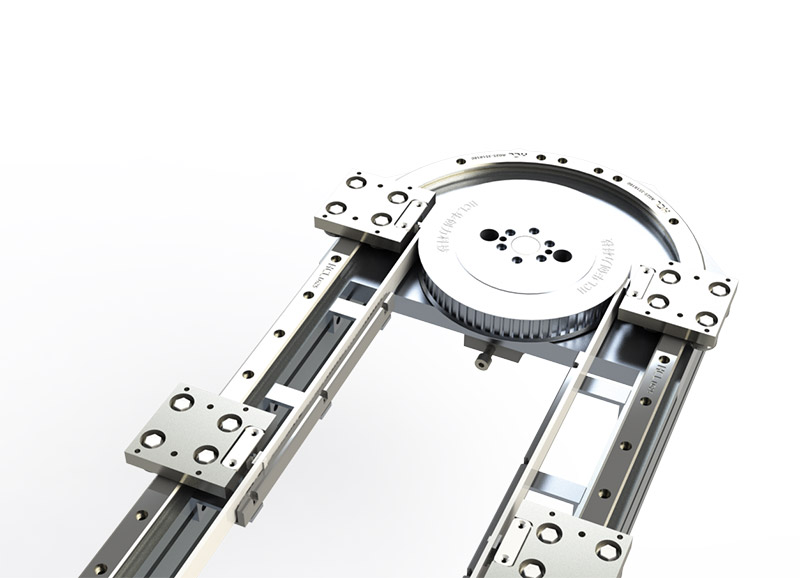

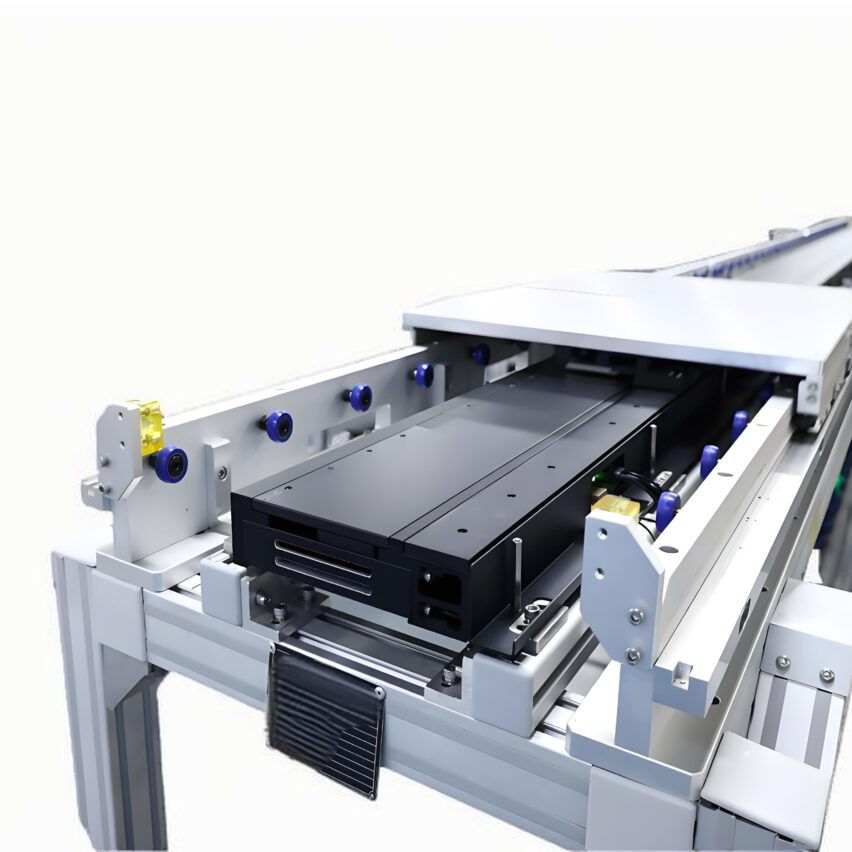

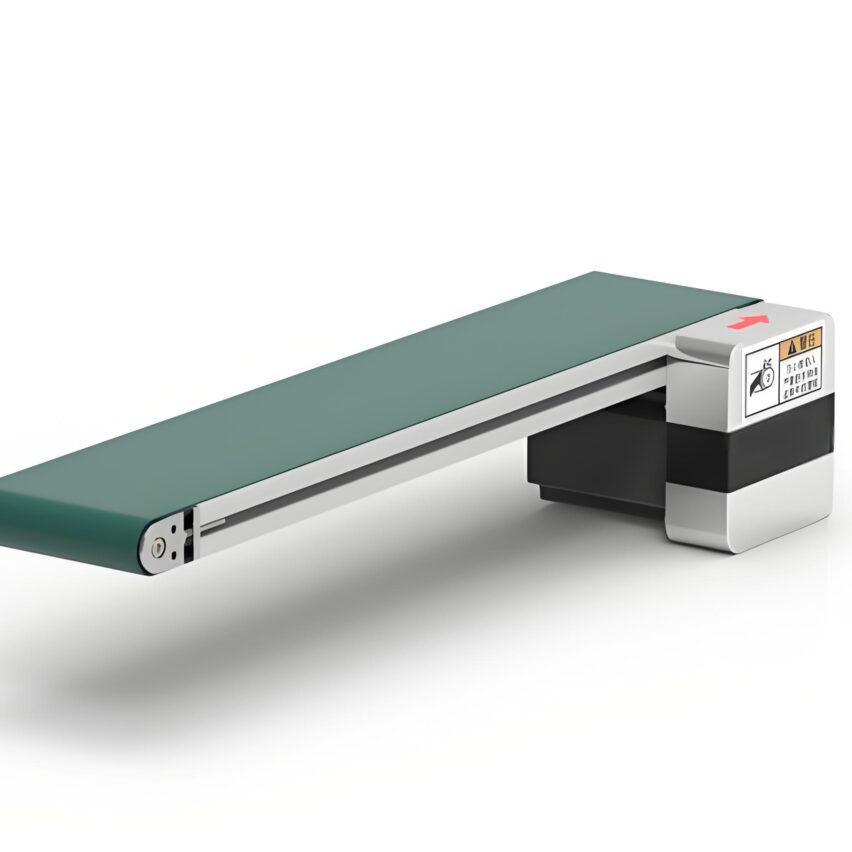

🤖 四、黑科技现场:智能磁驱输送线

传统皮带输送带硬伤太多——打滑、抖动、维护贵… 现在爆火的磁驱输送线直接颠覆玩法:

| 对比项 | 传统皮带线 | 智能磁驱线 |

|---|---|---|

| 控制方式 | 所有工件同步移动 | 每个动子独立控制🚀 |

| 精度 | ±5mm | ±0.1mm |

| 防撞能力 | 靠间距硬防 | 算法实时规划避障路径🤖 |

| 维护成本 | 每月换皮带、调张力 | 动子免维护,寿命5年+ |

运作原理贼酷:

- 输送线变成”磁悬浮轨道”,载具(动子)靠电磁力推进;

- 视觉系统识别物料位置,通过EtherCAT总线告诉控制器;

- 控制器用多动子防撞算法,指挥254个动子自由加减速、避让;

- 动子载着零件精准停到机械手前,误差不到头发丝粗细!

某家电厂用这套系统,生产线效率飙升40%,还省了3台冗余机械手!💰

💡 独家见解:未来已来,但别踩这些坑!

干了十年视觉集成的老工程师私下说:

- 别贪便宜相机:帧率<200fps拍高速线?等着哭吧!宁可多花2万买千兆网相机;

- 光源是灵魂:某项目因车间窗边光变化,下午3点后定位全崩… 后来加了偏振片才解决;

- 警惕”算法迷信”:简单场景用传统算法更稳(比如规则零件定位),别硬上深度学习折腾自己!

终极心法⚡:

精准定位 = 硬件稳如狗 × 软件快如刀 × 工程细节抠到毛孔

流水线上的零件还在飞奔,但有了这些技术——它们再也逃不过机器的”火眼金睛”!👁️🗨️ 下次看到机械手行云流水抓零件,你就能傲娇地说:”瞅见没?这套路我门儿清!”